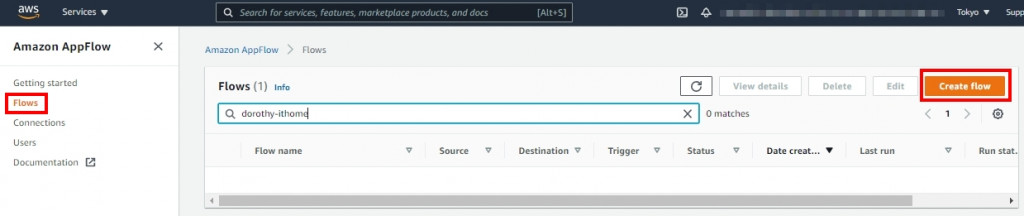

大家好~昨天我們建立好 Google Analytics 與 AWS 連線,現在我們就可以透過 AWS Console 拉取 Google Analytics 資料

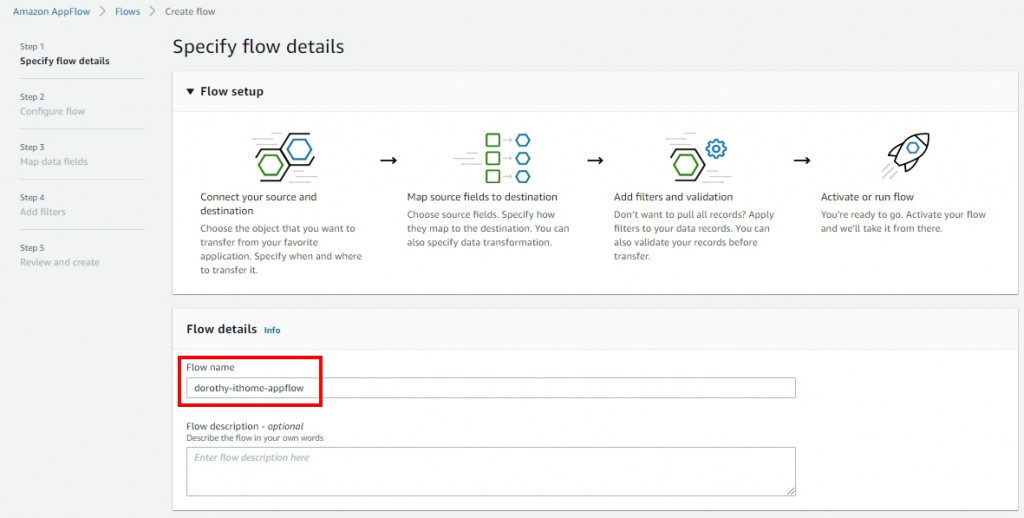

大致流程如下所示:

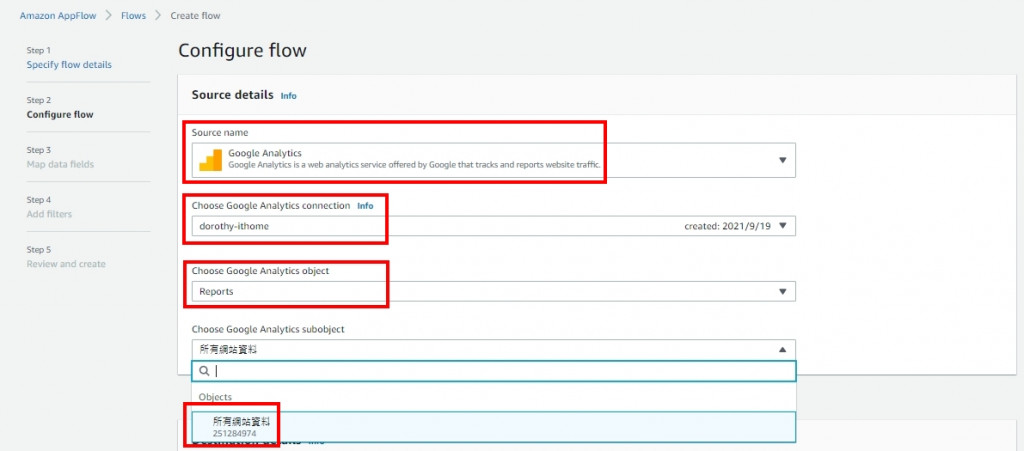

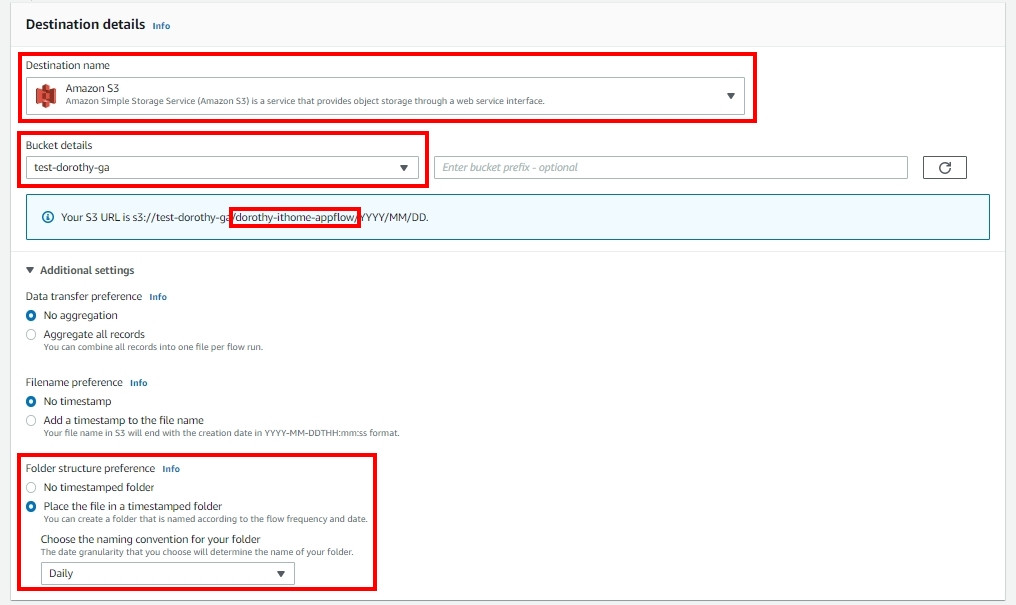

這裡是定義抓取的 Google Analytics 資料要存放在哪裡

所以我們這邊選擇 Destination name 為 AWS S3、Bucket details 選擇昨天創建的 S3 Bucket name,接著展開 Additional settings

選擇完後,藍底的地方就會顯示目前資料夾的命名階層:

S3://<<"bucket name">>/<<"appflow name">>/年/月/日

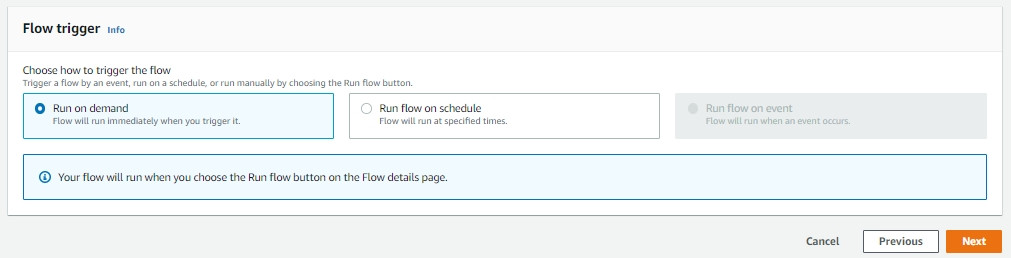

可以選擇按排程、基於事件或手動觸發,這邊我們選擇 Run on demand (手動觸發)

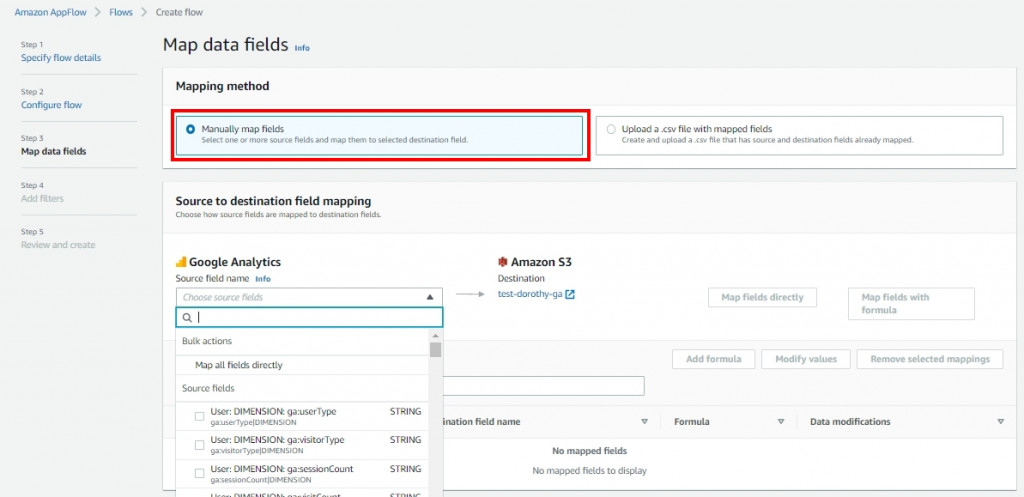

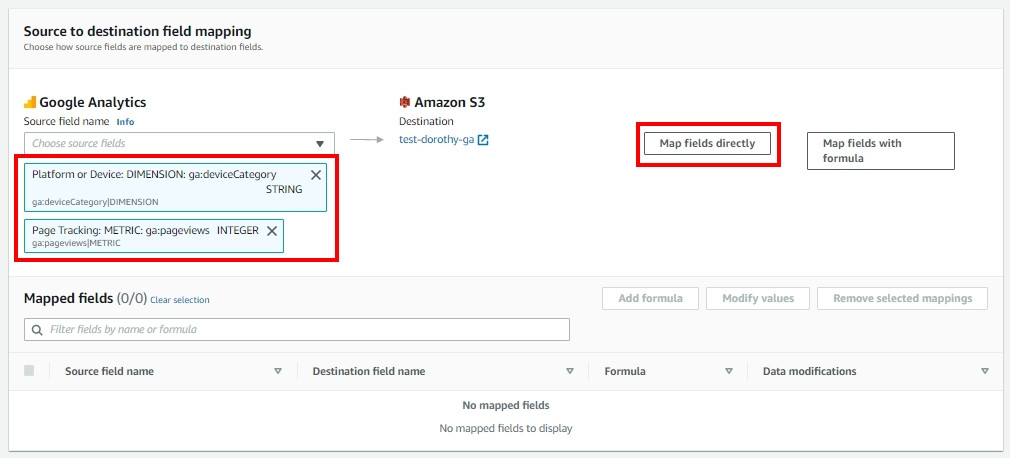

選擇 Manually map fields,並選取欲拉取的 Google Analytics 欄位(欄位說明請詳[1]),這邊我想瞭解不同的裝置在網站的網頁瀏覽量,故選取

ga:date|DIMENSION、ga:deviceCategory|DIMENSION、ga:pageviews|METRIC,並點選 Map fields directly 後按 Next

★小叮嚀★ 因有部分欄位無法直接選取(ex:ga:dimensionXX),可以選擇『Upload a .csv file with mapped fields』,就可以導入自定義維度和指標。

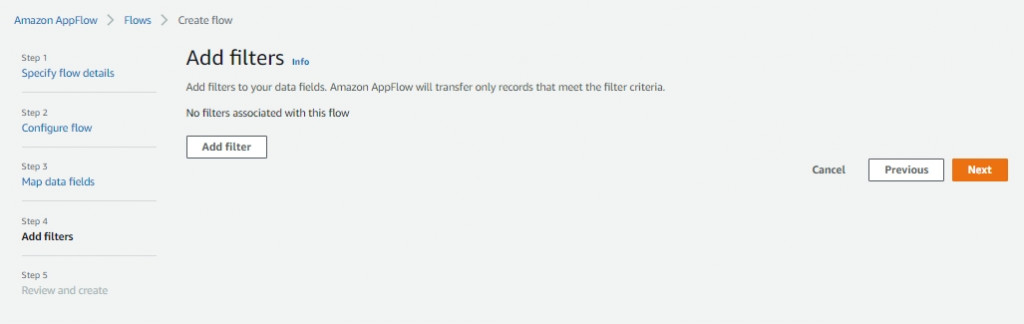

我們可以設定篩選條件過濾要儲存的資料,我們選擇跳過按 next、save

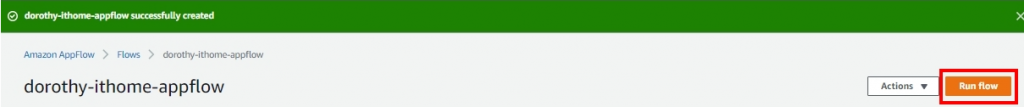

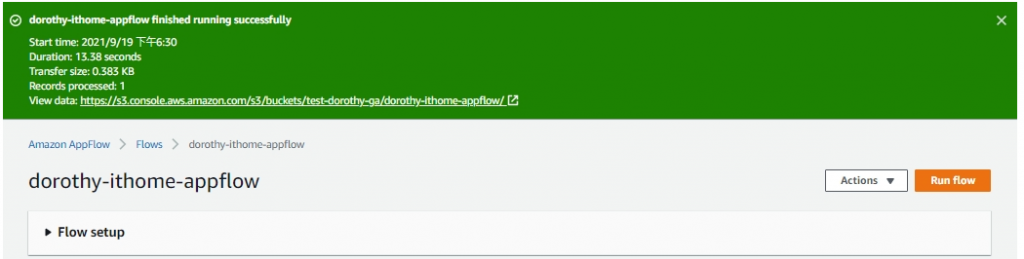

接著我們點擊此 Flow 並點選 Run Flow

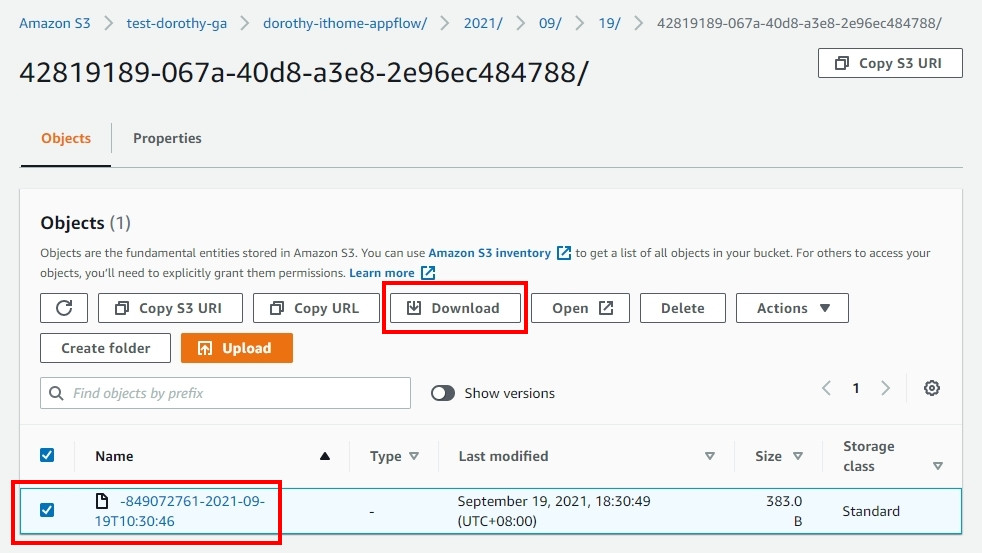

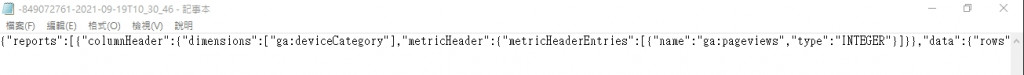

等待 Flow 執行完成後,我們可以在 S3 看到抓取的 Google Analytics 資料~接著我們下載這個檔案看裡面的內容,我們會發現抓取的 Google Analytics 原始檔案為多行的 JSON 格式,非常不方便使用者閱讀且 Athena 也不支援此格式搜尋,讓我們無法進行後續的分析處理

我們要如何解決此問題呢? 就讓我們明天繼續討論 Data Analytics Pipeline on AWS - Google Analytics 吧~ 明天見:)

如果有任何指點與建議,也歡迎留言交流,一起漫步在 Data on AWS 中。

[1] UA Dimensions & Metrics Explorer

https://ga-dev-tools.web.app/dimensions-metrics-explorer/